IDIOMA:

- QUÉ HACEMOS

- IA GENERATIVA

Creamos, transformamos, probamos y enseñamos más contenido que nadie en el mundo, desde texto, voz, audio, vídeo, hasta datos estructurados y sin estructurar.

Centros de conocimientos de Lionbridge

- Resultados positivos del paciente

- El futuro de la localización

- La innovación al servicio de la inmunidad

Aproveche la tecnología mejorada con IA para impulsar sus comunicaciones globales.

- SECTORES

- LAⁱNGUAGE CLOUD™

Nuestros expertos conocen los pormenores del sector y sus dificultades.

Utilice las prestaciones y ventajas de Lionbridge Lainguage Cloud para el ciclo del contenido y la localización

- QUIÉNES SOMOS

Creamos, transformamos, probamos y enseñamos más contenido que nadie en el mundo, desde texto, voz, audio, vídeo, hasta datos estructurados y sin estructurar.

Servicios de contenido

- Redacción técnica

- Formación y aprendizaje electrónico

- Informes financieros

- Evaluaciones de la experiencia digital

- Marketing digital

- Optimización de contenido

Servicios de traducción

- Localización de vídeo

- Localización de software

- Localización de sitios web

- Traducción para empresas reguladas

- Interpretación

- Eventos en directo

Servicios de pruebas

- Pruebas y controles de calidad funcionales

- Pruebas de compatibilidad

- Pruebas de interoperabilidad

- Pruebas de rendimiento

- Pruebas de accesibilidad

- Prueba UX/CX

Soluciones

- Modelos de servicio de traducción

- Traducción automática

- Smart Onboarding™

Nuestros Centros de conocimientos

- Resultados positivos del paciente

- El futuro de la localización

- La innovación al servicio de la inmunidad

- Centro de recursos lingüísticos para la COVID-19

- Serie Tiempos de cambio

- Compromiso del paciente

- Monográficos de Lionbridge

Aproveche la tecnología mejorada con IA para impulsar sus comunicaciones globales.

IA generativa

Soluciones de marketing basadas en IA generativa

Nuestros expertos conocen los pormenores del sector y sus dificultades.

Sector biomédico

- Sector farmacéutico

- Aspectos clínicos

- Cuestiones normativas

- Actividades posteriores a la aprobación

- Ámbito corporativo

- Productos sanitarios

- Validación e investigaciones clínicas

- Cuestiones normativas

- Actividades posteriores a la autorización

- Ámbito corporativo

Banca y finanzas

Minorista

Lujo

Comercio electrónico

Lionbridge Games

Automoción

Bienes de consumo envasados

Tecnología

Fabricación industrial

Servicios jurídicos

Viajes / Hostelería

Utilice las prestaciones y ventajas de Lionbridge Lainguage Cloud para el ciclo del contenido y la localización

Lainguage Cloud™ Plataforma

Conectividad

Comunidad de traducción

Software TMS

Smairt Content™

Smairt MT™

Smairt Data™

Nuestra gente es nuestro orgullo. Más de 20 años ayudando a las empresas a conectar con sus clientes.

Acerca de nosotros

Datos importantes

Liderazgo

Centro de confianza

SELECCIONAR IDIOMA:

¿Qué le deparará el futuro a la traducción automática (TA)? He ahí una pregunta sobre la que meditamos día sí y día también en Lionbridge.

A lo largo de 2022, los principales motores de traducción automática (Google NMT, Bing NMT, Amazon, DeepL y Yandex) apenas han registrado avances en términos de calidad. Para comprobarlo, basta con echar un vistazo a nuestro Machine Translation Tracker, la herramienta de seguimiento de la evolución de la TA que más tiempo lleva realizando este tipo de evaluación en el sector. Estos resultados poco vistosos nos han llevado a plantearnos algunas preguntas sobre el actual paradigma de la traducción automática neuronal (NMT).

- ¿El paradigma de la NMT se está estancando?

- ¿Es necesario un nuevo cambio de paradigma, a tenor de la incapacidad de los motores para seguir consiguiendo avances relevantes?

- ¿Qué depara el futuro?

En nuestra opinión, los modelos lingüísticos de gran tamaño (LLM) —con sus ingentes volúmenes de contenido y su capacidad multimodo y multilingüe— tendrán cierta relevancia en el futuro paradigma. ¿Por qué creemos esto? Por los resultados que arroja nuestro análisis revolucionario en el que se compara el rendimiento de ChatGPT en tareas de traducción con el de los motores de TA.

ChatGPT, la última versión publicada por OpenAI de GPT-3, su familia de LLM, generó unos resultados peores que los de los motores de TA elegidos, pero no por mucho. Su rendimiento fue notable, simple y llanamente, y no hay duda de que esto posee ciertas implicaciones para el futuro de la traducción automática.

¿Por qué podría estar fraguándose un nuevo paradigma de traducción automática?

Las tendencias actuales que observamos en los motores de TA nos sugieren que estamos ante un déjà vu.

Hacia el final de la etapa de dominio de la traducción automática estadística, a la que siguió el período de hegemonía de la NMT, apenas se registraban cambios en el grado que calidad que ofrecía la TA. Además, la calidad ofrecida por los distintos motores de TA se unificó. Actualmente, nos encontramos en una situación muy similar.

Aunque puede que la NMT no se vaya a sustituir de inmediato, si creemos en las teorías de la aceleración de ganancias y el crecimiento exponencial, si consideramos la evolución a lo largo de 30 años de la TA basada en reglas y el protagonismo acaparado por la TA estadística durante una década, y si tenemos en cuenta que la NMT se encuentra, actualmente, en su sexto año de predominio, podemos concluir que es posible que pronto se produzca un cambio de paradigma.

¿Cuál podría ser el siguiente paradigma de la traducción automática?

Los grandes avances introducidos en los LLM a lo largo de 2022 han allanado el terreno para la introducción de esta tecnología en el campo de la TA en 2023.

Los LLM son modelos genéricos que han sido entrenados para hacer numerosas cosas. Sin embargo, hemos observado que, hacia finales de 2022, algunos LLM específicos, o perfeccionados, habían conseguido ciertos avances esenciales en algunos ámbitos concretos. Gracias a estos avances y con un poco de entrenamiento adicional, esta tecnología ya es capaz de realizar traducciones.

Pensemos, por ejemplo, en ChatGPT. OpenAI ha perfeccionado su modelo más reciente de manera que pueda interactuar con los usuarios a través de diálogos compuestos por preguntas y respuestas, al tiempo que sigue siendo capaz de realizar todo aquello que los LLM pueden hacer.

Es posible que con la traducción suceda algo similar, cuando se desarrollen LLM adaptados para este tipo de tarea.

¿De qué modo habría que perfeccionar los modelos de lenguaje de gran tamaño para que puedan realizar traducciones?

Si los motores se entrenasen con corpus lingüísticos más equilibrados, sería más probable emplear los LLM para llevar a cabo traducciones.

El corpus de entrenamiento de GPT-3 estaba compuesto por un 93 % de textos en inglés; solamente un 7 % de los corpus se encontraban en otros idiomas. Si GPT-4, cuyo lanzamiento parece que tendrá lugar próximamente, incluye más corpus en otros idiomas distintos del inglés, puede que asistamos a la aparición de nuevos LLM mejor preparados para abordar el multilingüismo y, por tanto, la traducción. Además, este corpus más equilibrado desde el punto de vista lingüístico puede servir de base para desarrollar un modelo perfeccionado especializado en traducción.

Otro aspecto interesante de este hipotético nuevo paradigma de TA basado en los LLM es la tendencia de la multimodalidad. Podemos entrenar a los LLM empleando datos de entrenamiento lingüísticos y de otro tipo, como imágenes y vídeo. Este tipo de entrenamiento puede aportar un conocimiento adicional sobre el mundo para lograr mejores traducciones.

¿Serán los modelos de lenguaje de gran tamaño una buena alternativa al paradigma de la traducción automática neuronal?

Para evaluar la promesa que representan los LLM de sustituir el paradigma de la NMT, hemos comparado el rendimiento de ChatGPT en tareas de traducción con el de los cinco principales motores de TA que empleamos en nuestro seguimiento de calidad de la TA.

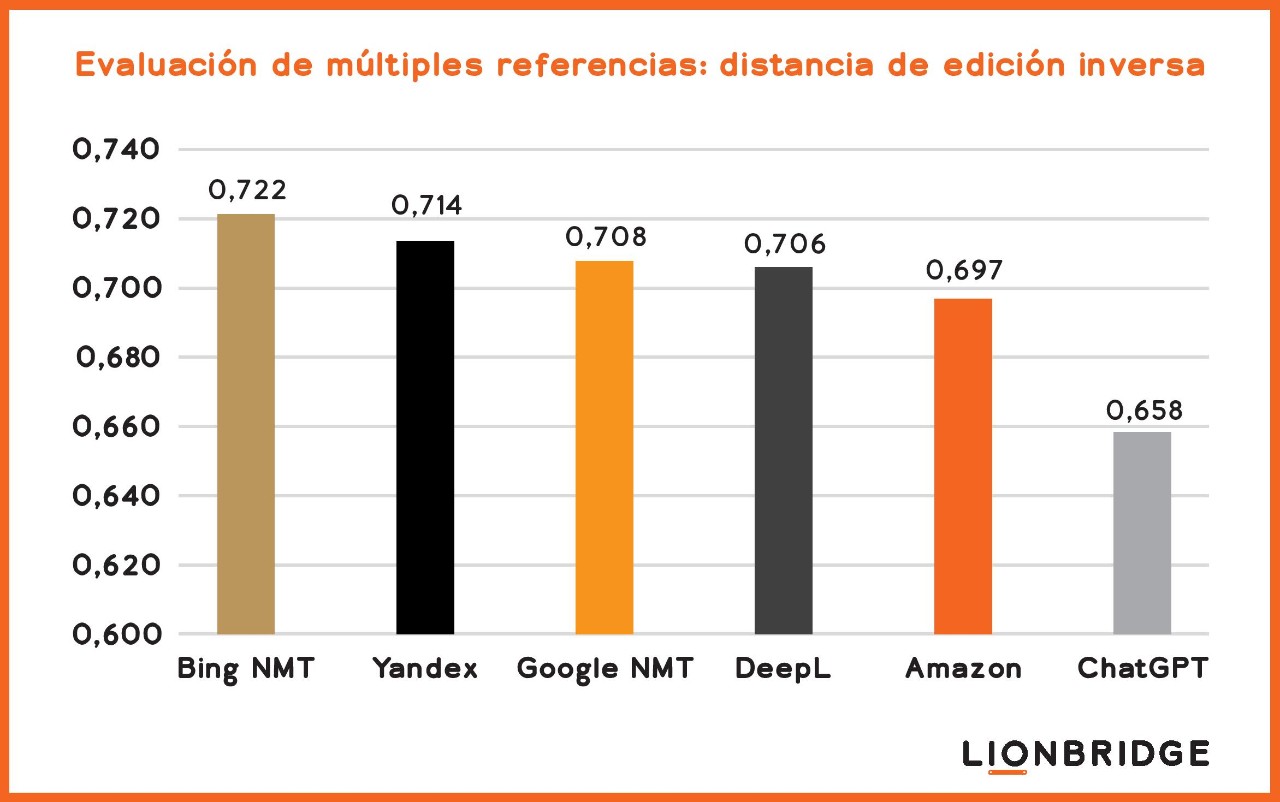

Tal y como esperábamos, los motores de NMT especializados traducen mejor que ChatGPT; sin embargo, ChatGPT logró realizar un trabajo decente, lo cual resulta sorprendente. Como se muestra en la figura 1, ChatGPT presentó un rendimiento casi tan bueno como el de los motores especializados.

¿Cómo hemos evaluado la calidad de ChatGPT en comparación con la de los motores genéricos de TA?

Hemos calculado el nivel de calidad de los motores tomando como base la distancia de edición inversa, empleando múltiples referencias para la combinación de idiomas de inglés a español. La distancia de edición mide el número de ediciones que un traductor humano debe realizar en el texto producido por una TA para que la traducción resultante sea igual de buena que una traducción humana. Para llevar a cabo nuestro cálculo, comparamos el resultado de la TA sin procesar con diez traducciones distintas realizadas por humanos, es decir, con múltiples referencias, y no solo con una única traducción humana. La distancia de edición inversa supone que cuanto mayor sea el número resultante, mejor será la calidad.

Figura 1. Comparación del grado de calidad de la traducción automática realizada por ChatGPT y los principales motores de traducción automática tomando como base la distancia de edición inversa y empleando múltiples referencias para la combinación de inglés a español.

¿Por qué son dignos de mención los resultados del rendimiento de ChatGPT en tareas de traducción?

Los resultados de nuestro análisis comparativo son dignos de mención porque el modelo genérico ha sido entrenado para realizar múltiples tareas de procesamiento del lenguaje natural (NLP, por sus siglas en inglés) distintas, a diferencia de lo que sucede con los motores de TA, que únicamente han sido entrenados para encargarse de una sola tarea de NLP: la traducción. Aunque ChatGPT no ha sido entrenado específicamente para realizar traducciones, su rendimiento a la hora de traducir presenta un nivel de calidad similar al que los motores de TA presentaban hace dos o tres años.

Lea las entradas de nuestro blog para obtener más información sobre ChatGPT y la localización.

¿Cómo podría evolucionar la traducción automática como resultado de los modelos lingüísticos de gran tamaño?

A tenor del crecimiento experimentado por los LLM —tomando como base la atención del público y las considerables inversiones que las empresas tecnológicas están realizando en esta tecnología—, pronto descubriremos si ChatGPT supera a los motores de TA o si la traducción automática empezará a adoptar un nuevo paradigma basado en los LLM.

La TA puede emplear los LLM como base y, después, perfeccionar la tecnología específicamente para la traducción automática. Esto sería algo similar a lo que OpenAI y otras empresas especializadas en LLM están haciendo para mejorar sus modelos genéricos para casos prácticos concretos, por ejemplo, para hacer posible que las máquinas se comuniquen con los seres humanos a través de conversaciones. La especialización añade precisión a las tareas realizadas.

¿Qué deparará el futuro a los modelos lingüísticos de gran tamaño en general?

El aspecto más destacado de estos modelos de lenguaje de gran tamaño «genéricos» es que pueden realizar múltiples cosas distintas y ofrecer una calidad extraordinaria en la mayoría de las tareas. Por ejemplo, GATO, el modelo de inteligencia general de DeepMind, se ha probado en más de 600 tareas y ha obtenido resultados punteros en 400 de ellas.

Actualmente, siguen existiendo dos líneas de desarrollo: los modelos genéricos, como GPT, Megatron y GATO; y los modelos especializados para fines concretos que se basan en estos modelos genéricos.

Los modelos genéricos son importantes porque permiten mejorar la inteligencia artificial fuerte (IAF) y, posiblemente, propiciarán avances todavía más impresionantes a largo plazo. Los modelos especializados tendrán usos prácticos a corto plazo en ámbitos concretos. Uno de los aspectos destacables sobre los LLM es que ambas líneas pueden avanzar y trabajar en paralelo.

¿Cuáles son las implicaciones que tendría un cambio de paradigma en la traducción automática?

A medida que el paradigma actual de la tecnología de traducción automática neuronal llega a su límite y surge un nuevo paradigma dominante en la tecnología de traducción automática —probablemente, basado en los LLM—, prevemos que se producirán ciertos cambios en la esfera de la TA. La mayoría de los efectos beneficiarán a las empresas, aunque prevemos que surjan problemas adicionales para aquellas que quieran realizar traducciones humanas.

Esto es lo que cabe esperar:

Mejoras en la calidad

La traducción automática experimentará un salto cualitativo a medida que los avances tecnológicos resuelvan cuestiones pendientes, como el uso del lenguaje formal e informal con la traducción automática y otros problemas de calidad relacionados con el tono. Los LLM incluso podrán resolver el mayor problema que presentan los motores de TA: su falta de conocimiento sobre el mundo. Este logro podrá hacerse posible gracias a su entrenamiento multimodal.

Los expertos en tecnología no solo entrenan a los LLM modernos con ingentes cantidades de texto, sino que también emplean imágenes y vídeo. Este tipo de entrenamiento permite a los LLM tener un conocimiento más vinculado que ayuda a las máquinas a interpretar el significado de los textos.

Mayor volumen de contenido obtenido y menor necesidad de traductores de primer nivel

Las empresas podrán crear más contenido más rápido, de manera que la creación de contenido crecerá más que el conjunto de traductores disponibles para traducir dicho contenido. Incluso con una mejora de la TA y un aumento de la productividad de los traductores, la comunidad de traducción continuará teniendo problemas para satisfacer las demandas de traducción.

Mayor adopción de la traducción automática

A medida que el nuevo paradigma tecnológico comience a estar disponible y que la traducción automática mejore su calidad, la demanda de servicios de traducción seguirá creciendo, lo que propiciará su adopción en más situaciones y casos prácticos.

El uso de la traducción automática para mejorar las experiencias del cliente

Con un incremento de la calidad de la TA y la necesidad de experiencias de cliente más personalizadas y a medida, las empresas recurrirán a la TA con más frecuencia para mejorar las experiencias digitales de los clientes de todo el mundo y crear relaciones más sólidas.

¿Cuál es la conclusión?

Las empresas tecnológicas están mostrando un tremendo interés en la tecnología de los LLM. Microsoft ha invertido 10 000 millones de dólares en OpenAI. Nvidia, Google y otras tecnológicas también realizan grandes inversiones en los LLM y la tecnología de IA.

Estamos muy intrigados por descubrir lo que nos deparará el futuro y, por ello, continuaremos evaluando los LLM. No se pierda este espacio para estar al día de estos avances tan emocionantes.

Póngase en contacto con nosotros

¿Quiere descubrir cómo Lionbridge le puede ayudar a aprovechar por completo la traducción automática? Póngase en contacto con nosotros hoy mismo.